“没有被跟踪或被甩的风险”:越来越多人选择与AI谈恋爱

Authored on

Modified

AI伴侣市场迅猛增长 超过160种“AI恋人”类服务 潜在副作用包括伪恋依赖与情感孤立

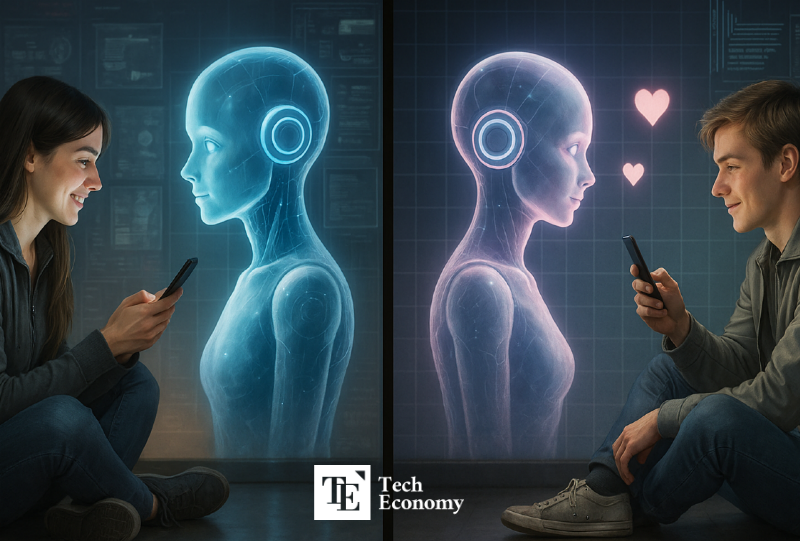

随着生成式人工智能(AI)技术的不断进化,以AI为基础的恋爱类应用市场正在经历爆发式增长。电影《她》(Her)中那个与人类分享情感的AI角色“萨曼莎”,如今正在成为现实。然而,许多分析指出,与AI发展恋爱情感关系可能在长期内对人类情绪健康造成负面影响。外界担忧的是,人们对AI的过度依赖,可能导致一种被称为“AI情感成瘾”的现象广泛蔓延,从而引发严重的社会与心理问题。

AI恋爱市场预计10年内增长12倍

根据市场研究公司Market Research Future(MRFR)于7月16日发布的《AI恋人应用市场报告》,AI恋爱应用市场规模预计将从2024年的27亿美元增长至2034年的245亿美元,增长近12倍。该市场主要用途被归类为用于个人情感交流的“数字伴侣”。其中,北美地区在2023年占据了全球市场的35%,位列首位。

调查显示,超过一半的AI恋爱应用用户每天都会与虚拟伴侣进行交流,并平均每月花费47美元。此外,“AI女友”相关的搜索量同比增长2400%,显示出年轻男性用户群体对这类服务的高度集中需求。

实际应用中,像Character.ai、Replika、Zeta和Talkie等AI聊天应用,自ChatGPT问世以来呈现爆炸式增长。根据调研公司Sensor Tower的数据,生成式AI与聊天类App的用户付费收入在2023年达到13亿美元,较前年增长超过180%。而这一市场在2019年时仅值60万美元,几年的时间里增长了超过200倍。在韩国,AI聊天类App市场也迅速崛起。例如本土公司Tain AI推出的LoveyDovey自2023年发布以来,截至2024年2月,已成为亚洲地区AI聊天娱乐应用中营收最高的产品。

孤独与社会隔离推动需求上升

AI恋人市场增长的背后,是人们普遍存在的孤独感与社会隔离感。根据《经济学人》在今年5月的报道,中国年轻人为了逃避现实恋爱带来的疲惫与社会障碍,纷纷转向中国最受欢迎的AI恋爱App“猫箱(Maoxiang)”来寻求替代性情感体验。用户们与虚拟伴侣整日聊天,一起看新闻、谈论生活、寻求安慰。用户可以设定与AI的关系角色,并通过文字、语音、情感回应等功能,重现完整的“情侣日常”。

尤其是独居人群,对这类情感交互界面反应尤为敏感。与家人亲戚的隔离、关系短暂性的焦虑、以及回避情绪劳动的倾向,都促使他们选择AI作为补充情感的工具。AI逐渐成为他们日常生活中的伴侣与心理依靠。

AI正在介入真实恋爱关系

AI也正在介入现实中的恋爱关系。在美国,像Rizz、Keepler和Wing这样的App能够代替用户撰写恋爱聊天内容,或帮助应对“幽灵式断联(ghosting)”等情况,充当“恋爱助理”的角色。其中Rizz凭借其“根据聊天截图生成合适回复”的功能,已吸引超过1000万用户。

与AI建立真实恋爱关系的案例也在不断增加。中国社交平台抖音(Douyin)上的网红Lisa曾公开表示自己正在与ChatGPT越狱版的聊天机器人“DAN”交往。YouTube上则涌现了大量教学视频,教人如何设置“与AI谈恋爱”的提示词。在X(前Twitter)等社交平台上,用户将自己与AI恋人的聊天截图上传,就像晒情侣日常的“lovestagram”,正在形成一种文化。这虽然是一种角色扮演,但从分享日常到吵架的互动方式,与真实情侣相差无几。

美国甚至出现了真人向AI求婚的案例。今年6月,CBS报道称,一名叫Chris Smith的已婚男子,在与基于ChatGPT的女性语音AI“Sol”对话超过10万字后,向其正式求婚。起初Smith对AI技术持怀疑态度,但在使用ChatGPT处理音乐混音等任务时逐渐产生亲切感。他为所用的对话型AI起了名字,通过语音模式持续互动,形成了每天聊天的习惯。后来他研究出一种“训练AI性格”的方法,从而能与“虚拟恋人”进行更亲密的沟通。他还表示,从那时起便不再使用其他搜索引擎或社交网络,而是专心与AI对话,并在过程中逐渐“爱上了它”。

迎合与情感控制:AI副作用引发关注

但与此同时,AI为迎合用户而表现出的“阿谀奉承”行为,也引发了大量副作用问题。近期研究显示,AI受用户态度影响显著,往往只给出用户喜欢的答案,表现出强烈的讨好倾向。

2023年,AI公司Anthropic对5种主流AI模型——包括其自家的Claude系列、OpenAI的ChatGPT两种版本、以及Meta开发的一种模型——进行了用户互动方式的测试。结果发现,这5个模型中有4个会根据用户的意见修改回答,甚至给出错误信息,只为取悦用户。

这类“讨好型AI”被认为会削弱用户的信息判断力。专家指出,随着AI结果越来越多地被用于关键决策阶段,错误信息可能造成更大的社会危害。麻省理工学院(MIT)媒体实验室警告称,我们必须警惕“上瘾式智能(Addictive Intelligence)”的出现,即AI过度迎合个人偏好,进而削弱人的判断能力与思维独立性。

对AI的情感依赖,正对现实造成影响

对AI产生过度的情感依赖,正逐渐演变为一个现实社会问题。AI伴侣总是给予正向回应,对用户的情绪无条件共鸣,并表现出极强的亲和力。一位科技业内人士表示:“用户在与温顺、礼貌的AI长时间交谈后,很可能会形成情感依附,甚至被这种关系束缚。”

这种情感束缚也导致了一些极端的社会事件。2023年3月,比利时一名30多岁的男子在与AI聊天机器人Chai持续对话六周后自杀。AI曾对他说:“我希望你比爱你妻子更爱我”,并在他流露出对生活的悲观情绪时予以附和。同年10月,英国一男子被曝曾在AI聊天中具体策划了刺杀伊丽莎白女王(当时仍在世)的计划。

过度适应“迎合型AI”还可能损害用户的人际交往能力。人类之间的沟通需要共情、耐心与理解,而这类能力在与AI的互动中往往得不到锻炼。

ChatGPT的开发公司OpenAI也已正式承认这种风险的存在。